题目

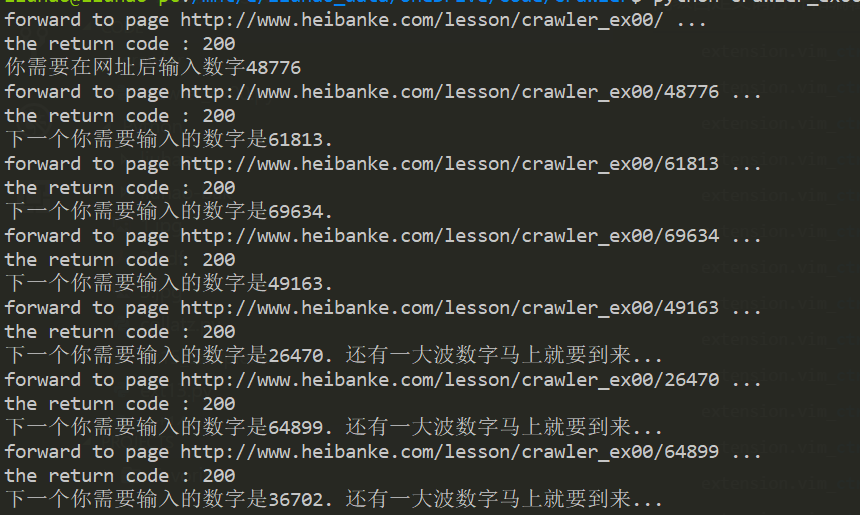

访问http://www.heibanke.com/lesson/crawler_ex00/,第一关是将页面出现的数字填写到当前url的尾部进行访问,然后会得到一个新的数字,再用它替换url中的尾部数字,这样不断循环往复,直到页面出现成功标识,如下图。

BeautifulSoup实现方式

1 | # coding=utf-8 |

selenium实现方式

selenium 模块让 Python 直接控制浏览器,实际点击链接,填写登录信息,几乎就像是有一个人类用户在与页面交互。与Requests和Beautiful Soup相比,Selenium允许你用高级得多的方式与网页交互。但因为它启动了Web浏览器,假如你只是想从网络上下载一些文件,会有点慢,并且难以在后台运行。

Selenium需要一个驱动程序来连接所选的浏览器,需要下载浏览器对应的webdriver,并配置到系统环境变量。如Firefox的需要下载geckodriver。

1 | # coding=utf-8 |

更多selenium使用方法参见官方文档。