题目

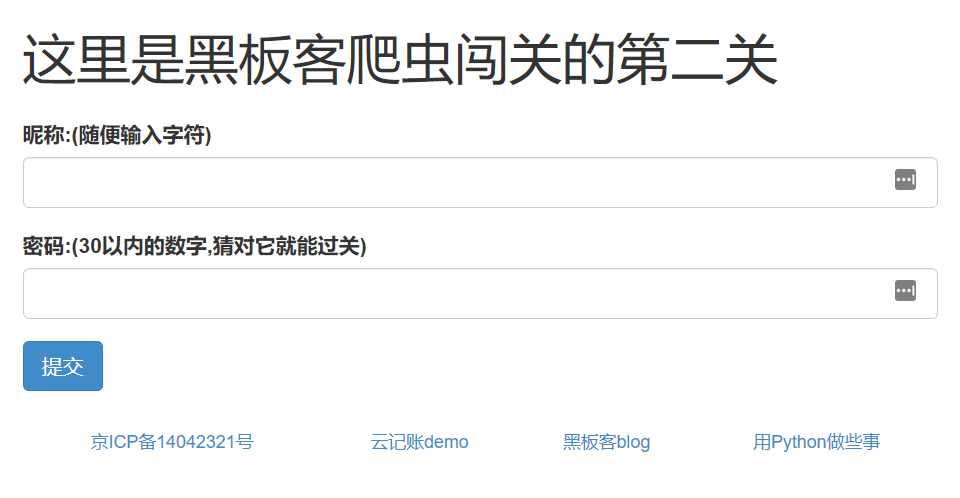

题目地址访问http://www.heibanke.com/lesson/crawler_ex01/,如图:

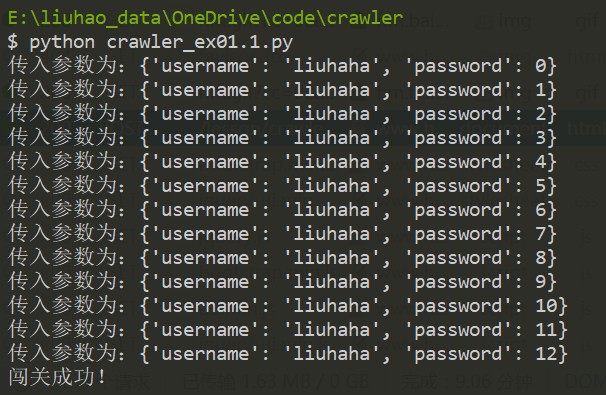

使用requests实现

1 | # coding=utf-8 |

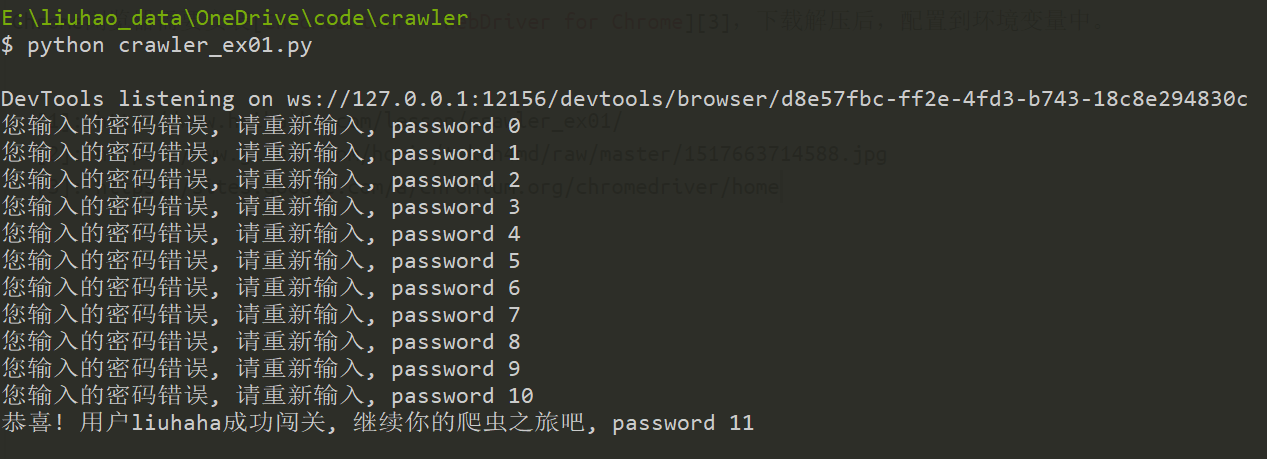

使用selenium实现

环境:Firefox58,Chrome64。

在刚开始使用Firefox调用WebElement的submit()方法后,发现submit()方法没有等到页面重新加载完毕就返回,这就导致我们在查找页面元素时无法找到我们想要的东西。而调用提交按钮的click()方法就一切正常。

Chrome浏览器需要安装ChromeDriver - WebDriver for Chrome,下载解压后,配置到环境变量中。

1 | # coding=utf-8 |